다운스트림 비전 작업에서 이미지 인코더만 활용하는 단점은 텍스트 인코더의 프롬프트 정보가 버려진다는 것입니다. 텍스트 인코더는 다운스트림 비전 작업의 성능에 기여할 수 있는 신속한 임베딩을 제공합니다. 따라서 다운스트림 작업의 미세 조정에서 두 인코더를 협력하여 이미지-텍스트 임베딩 간의 상호 작용을 조사하고 효율적인 모델 적응에서 그 효과를 이해할 수 있습니다.

효율적인 모델 적응은 데이터 효율적 및 매개 변수 효율적이라는 두 가지 방법으로 달성할 수 있습니다. 두 방법 모두 레이블이 지정된 데이터 및 모델 매개변수와 같은 관련 리소스를 줄임으로써 모델 학습 부담을 완화합니다. 전자는 소수/제로 샷 학습을 달성하는 데 도움이 될 수 있고 후자는 전체 매개변수의 작은 비율만 훈련하여 높은 성능을 달성할 수 있습니다. 신속한 컨텍스트 학습에는 두 가지 장점이 있습니다 .

프롬프트 컨텍스트 학습은 시각 언어 모델에 대한 효율적인 모델 적응을 달성하기 위해 프롬프트 벡터를 fine-tuning하는 방법입니다. 학습되지 않은 경우 프롬프트 컨텍스트는 인간이 생성하며 optimality은 알 수 없습니다. 이 게시물에서는 프롬프트 컨텍스트 학습의 최근 성과를 요약합니다.

CoOp 및 CoCoOp

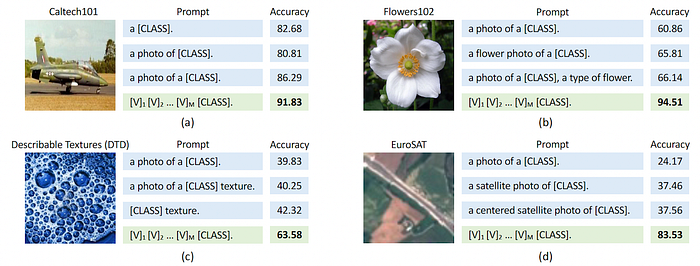

위의 이미지를 살펴보면, prompt contex 학습의 도움으로 정확도는 모두 다양한 평가 데이터 세트에 대해 크게 증가합니다. 해당 논문에선 총 11개의 데이터세트를 통해 검증합니다.

그중 특히 EuroSAT와 같은 일부 특수 데이터 세트의 경우 정확도가 약 30에서 80 이상으로 놀라울 정도로 증가합니다.

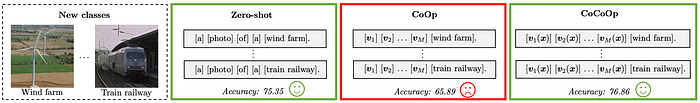

CoOp은 최초의 prompt context learning 아키텍처입니다. CoOp와 CLIP의 유일한 차이점은 왼쪽 상단 부분인 학습 가능한 컨텍스트입니다. fine-tuning 중에는 이 부분만 역전파를 통해 업데이트됩니다.

그러나 CoOp의 단점은 학습된 클래스의 과적합으로 인해 일반화 가능성이 낮다는 것입니다. 위에 표시된 것처럼 'Train railway'와 같이 보이지 않는 클래스에서 평가할 때 정확도가 떨어집니다.

CoOp에서 고정된 텍스트 인코더는 입력 문장이 인간이 만든 프롬프트 컨텍스트와 보이지 않는 클래스 이름에 의해 결합될 때 CLIP처럼 강력한 제로샷 일반화 가능성을 갖습니다.

그러나 CLIP의 제로샷 일반화 가능성은 학습된 프롬프트 컨텍스트에 대해 보존되지 않습니다 .

위와 같이 동일한 저자가 CoCoOp를 제안하여 기존 CoOp을 확장시켰습니다. CoOp의 한계점이었던 원래 CLIP의 제로샷 일반화 가능성을 되살렸습니다. 프롬프트 컨텍스트 학습에서 각 입력 이미지를 조건으로 사용하여 구현합니다. 인코딩된 이미지 임베딩은 각 컨텍스트 토큰에 추가되는 조건부 메타 토큰 π 를 생성하기 위해 두 레이어 병목 하위 네트워크인 Meta -Net 을 통과합니다. 학습 중에는 Meta-Net 및 컨텍스트 토큰 벡터만 역전파로 미세 조정됩니다.

추론 중에 보이지 않는 클래스의 이미지 임베딩은 학습된 컨텍스트 토큰과 융합되어 동적(dynamically)으로 텍스트 임베딩을 생성합니다. 이 동적 텍스트 임베딩에는 보이지 않는 해당 클래스 이미지의 정보가 포함되어 있기 때문에 해당 이미지 임베딩과 정렬될 가능성이 높고 제로샷 성능이 향상됩니다.

CoCoOp와 달리 CoOp는 이미지 컨디셔닝 없이 프롬프트 컨텍스트를 학습하므로 정적(static) 프롬프트 컨텍스트가 생성됩니다. 따라서 제로 샷 추론 중에 표시되지 않는 입력 클래스 이미지와 무관한 과적합 프롬프트 컨텍스트를 사용하면 성능이 크게 떨어집니다. CLIP에서 인간이 설계한 프롬프트 컨텍스트는 중립적이며 과적합될 수 없습니다. 이것이 CLIP이 제로샷 일반화 가능성이 강한 이유 중 하나일 것입니다.

'AI > Deep Learning' 카테고리의 다른 글

| Style Transfer와 GAN 그리고 StyleGAN (0) | 2023.06.06 |

|---|---|

| 이미지 태깅(Image Tagging)이란? (0) | 2023.04.29 |

| Contrastive Pre-training of Visual Language Models (0) | 2023.04.16 |

| Open Set Learning이란? (0) | 2023.04.14 |

| Fine-Grained Image Classification이란? (0) | 2023.04.14 |

댓글